Ollama的魅力——大模型時代的“平民英雄”

在人工智能浪潮席卷全球的今天,大語言模型(LLM)無疑是最耀眼的明星。然而,對于許多初學者和開發者而言,大模型的部署和使用門檻依然不低。正是在這樣的背景下,Ollama應運而生,并迅速以其極致的易用性俘獲了大量用戶的心。

Ollama的設計哲學可以概括為“一鍵啟動”。用戶無需關心復雜的環境配置和模型加載流程,只需一條簡單的命令,即可在本地輕松運行和管理像Llama 3、Mistral等主流的開源大模型。這種“開箱即用”的體驗,極大地降低了開發者和研究人員進入大模型領域的門檻。可以說,Ollama是許多人探索大模型世界的第一個“腳手架”,是他們學習和實驗的得力助手。正是因為這種無與倫比的便捷性,Ollama的用戶基數非常龐大,在開發者社區中擁有極高的聲譽和使用量。

然而,Ollama在為用戶帶來便利的同時,也埋下了一顆危險的“定時炸彈”——安全性的缺失。令人驚訝的是,直到目前為止,Ollama仍然沒有內置任何形式的身份驗證或訪問控制機制。 這意味著,一旦Ollama的服務端口(默認為11434)被暴露在公共網絡上,任何能夠訪問該端口的人,都可以不受限制地調用其所有的API接口。

這種“不設防”的狀態帶來了嚴重的安全隱患。攻擊者可以像使用自家的本地服務一樣,對暴露在外的Ollama實例為所欲為。以下是一些可能被利用的敏感操作:

事實上,目前已知的多個與Ollama相關的安全漏洞,其根源幾乎都指向了這個致命的缺陷——未經身份驗證的訪問。

Ollama默認監聽的是本地回環地址(127.0.0.1),這在設計上是安全的。但問題在于,很多用戶為了方便遠程訪問或在容器化環境中部署,會將其配置為監聽所有網絡接口(0.0.0.0)。這一小小的改動,如果沒有其他網絡層面的防護(如防火墻),就相當于將Ollama完全暴露在了廣闊的互聯網上。

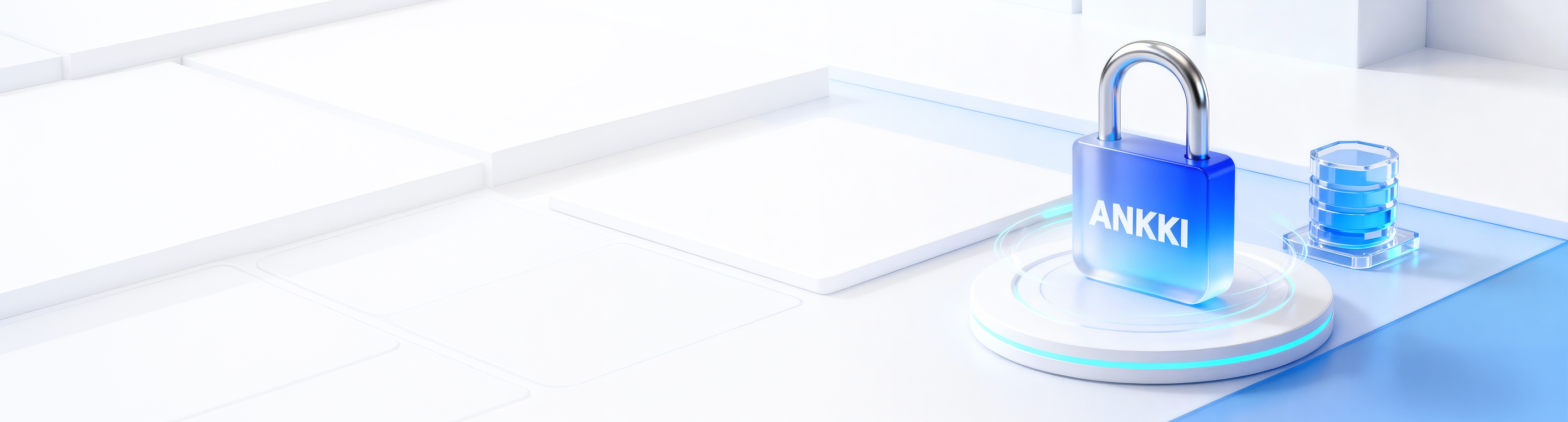

根據最新的全球網絡空間掃描數據顯示,當前有幾十萬個Ollama實例正毫無防護地暴露在公網上。

這個數字是觸目驚心的。每一個暴露的實例都是一個潛在的受害者,其背后可能連接著個人的開發項目、企業的內部數據,甚至是敏感的研究成果。這些用戶或許根本沒有意識到,自己精心調試的模型和寶貴的計算資源,正處于隨時可能被“白嫖”甚至惡意利用的危險之中。

亡羊補牢,為時未晚。既然Ollama自身不提供安全機制,我們就需要借助外部工具來構建一道堅固的防線。以下是兩種主流且行之有效的解決方案。

最直接的思路是在Ollama前面架設一個反向代理服務器,例如Nginx、Caddy或Apache。由反向代理來負責處理所有傳入的請求,并在這里添加身份驗證機制。

以Nginx為例,我們可以輕松地為其配置HTTP Basic Authentication。這樣,任何訪問者在接觸到Ollama的API之前,都必須提供預設的用戶名和密碼。這種方式實現簡單,可以快速地為你的Ollama服務提供一層基礎的保護,有效阻止未經授權的訪問。

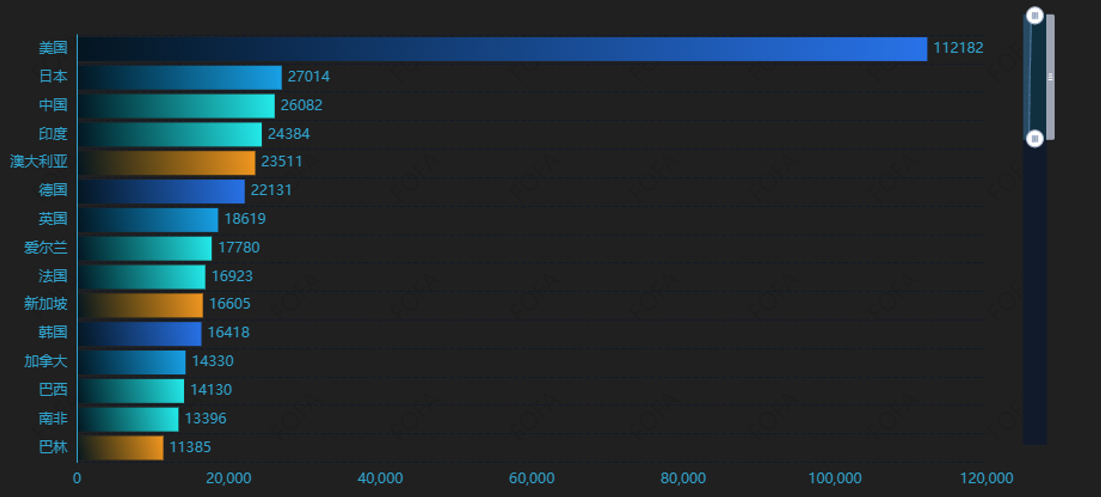

相比于反向代理的“一刀切”式防護,昂楷API網關提供了更為精細化和強大的訪問控制能力。昂楷API網關不僅能實現身份認證,還能對API進行更細致的權限管理,例如限制特定API的訪問、流量控制、日志記錄等。

這種方案的優勢在于,我們可以根據實際需求,制定差異化的安全策略。例如,我們可以設想這樣一個場景:允許外部用戶通過 API調用模型進行推理(訪問api/generate/或/api/chat接口),但絕對禁止他們創建、刪除或修改模型(禁止訪問/api/create、/api/delete、/api/push等高危接口)。

(阻斷了除/api/generate、/api/chat之外的所有接口)

通過昂楷API網關,我們可以輕松實現這種策略。我們可以配置網關,為不同的API路徑設置不同的認證和授權規則。只有通過認證且具備相應權限的用戶,才能訪問特定API。

這種方式不僅提升了安全性,也增強了服務的可管理性和擴展性,是企業級應用場景下的更優選擇。

Ollama的成功,在于它將復雜的技術變得簡單。但我們必須清醒地認識到,這種簡單性不應以犧牲安全為代價。將一個沒有任何訪問控制的服務暴露在互聯網上,無異于“裸奔”,是對自己和他人的不負責任。

幸運的是,我們有成熟的工具和策略來彌補這一短板。無論是簡單直接的反向代理,還是功能強大的API網關,都能有效地為你的 Ollama實例保駕護航。對于每一位正在享受Ollama便利的開發者而言,都應該立即行動起來,檢查自己的部署配置,為你的Ollama“穿上”必要的安全外衣。畢竟,在數字世界里,安全永遠是第一位的。